Python并行编程

- 本书说明

- 1 认识并行计算和Python

- 1.1 介绍

- 1.2 并行计算的内存架构

- 1.3 内存管理

- 1.4 并行编程模型

- 1.5 如何设计一个并行程序

- 1.6 如何评估并行程序的性能

- 1.7 介绍Python

- 1.8 并行世界的Python

- 1.9 介绍线程和进程

- 1.10 开始在Python中使用进程

- 1.11 开始在Python中使用线程

- 2 基于线程的并行

- 2.1 介绍

- 2.2 使用Python的线程模块

- 2.3 如何定义一个线程

- 2.4 如何确定当前的线程

- 2.5 如何实现一个线程

- 2.6 使用Lock进行线程同步

- 2.7 使用RLock进行线程同步

- 2.8 使用信号量进行线程同步

- 2.9 使用条件进行线程同步

- 2.10 使用事件进行线程同步

- 2.11 使用with语法

- 2.12 使用 queue 进行线程通信

- 2.13 评估多线程应用的性能

- 3 基于进程的并行

- 3.1 介绍

- 3.2 如何产生一个进程

- 3.3 如何为一个进程命名

- 3.4 如何在后台运行一个进程

- 3.5 如何杀掉一个进程

- 3.6 如何在子类中使用进程

- 3.7 如何在进程之间交换对象

- 3.8 进程如何同步

- 3.9 如何在进程之间管理状态

- 3.10 如何使用进程池

- 3.11 使用Python的mpi4py模块

- 3.12 点对点通讯

- 3.13 避免死锁问题

- 3.14 集体通讯:使用broadcast通讯

- 3.15 集体通讯:使用scatter通讯

- 3.16 集体通讯:使用gather通讯

- 3.17 使用Alltoall通讯

- 3.18 简化操作

- 3.19 如何优化通讯

- 4 异步编程

- 4.1 介绍

- 4.2 使用Python的 concurrent.futures 模块

- 4.3 使用Asyncio管理事件循环

- 4.4 使用Asyncio管理协程

- 4.5 使用Asyncio控制任务

- 4.6 使用Asyncio和Futures

- 5 分布式Python编程

- 5.1 介绍

- 5.2 使用Celery实现分布式任务

- 5.3 如何使用Celery创建任务

- 5.4 使用SCOOP进行科学计算

- 5.5 通过 SCOOP 使用 map 函数

- 5.6 使用Pyro4进行远程方法调用

- 5.7 使用 Pyro4 链接对象

- 5.8 使用Pyro4部署客户端-服务器应用

- 5.9 PyCSP和通信顺序进程

- 5.10 使用Disco进行MapReduce

- 5.11 使用RPyC远程调用

- 6 Python GPU编程

简化操作

同 comm.gather 一样, comm.reduce

接收一个数组,每一个元素是一个进程的输入,然后返回一个数组,每一个元素是进程的输出,返回给

root 进程。输出的元素中包含了简化的结果。

在 mpi4py 中,我们将简化操作定义如下: :

comm.Reduce(sendbuf, recvbuf, rank_of_root_process, op = type_of_reduction_operation)这里需要注意的是,这里有个参数 op 和 comm.gather

不同,它代表你想应用在数据上的操作, mpi4py

模块代表定义了一系列的简化操作,其中一些如下:

MPI.MAX: 返回最大的元素MPI.MIN: 返回最小的元素MPI.SUM: 对所有元素相加MPI.PROD: 对所有元素相乘MPI.LAND: 对所有元素进行逻辑操作MPI.MAXLOC: 返回最大值,以及拥有它的进程MPI.MINLOC: 返回最小值,以及拥有它的进程

如何做

现在,我们用 MPI.SUM

实验一下对结果进行相加的操作。每一个进程维护一个大小为 3 的数组,我们用

numpy 来操作这些数组: :

import numpy

import numpy as np

from mpi4py import MPI

comm = MPI.COMM_WORLD

size = comm.size

rank = comm.rank

array_size = 3

recvdata = numpy.zeros(array_size, dtype=numpy.int)

senddata = (rank+1)*numpy.arange(size,dtype=numpy.int)

print("process %s sending %s " % (rank , senddata))

comm.Reduce(senddata, recvdata, root=0, op=MPI.SUM)

print('on task', rank, 'after Reduce: data = ', recvdata)我们用通讯组进程数为 3 来运行,等于维护的数组的大小。输出的结果如下: :

C:\>mpiexec -n 3 python reduction2.py

process 2 sending [0 3 6]

on task 2 after Reduce: data = [0 0 0]

process 1 sending [0 2 4]

on task 1 after Reduce: data = [0 0 0]

process 0 sending [0 1 2]

on task 0 after Reduce: data = [ 0 6 12]讨论

为了演示相加简化操作,我们使用 comm.Reduce 语句,并将含有 recvbuf 的

rank 设置为 0, recvdata 代表了最后的计算结果: :

comm.Reduce(senddata, recvdata, root=0, op=MPI.SUM)我们的 op = MPI.SUM

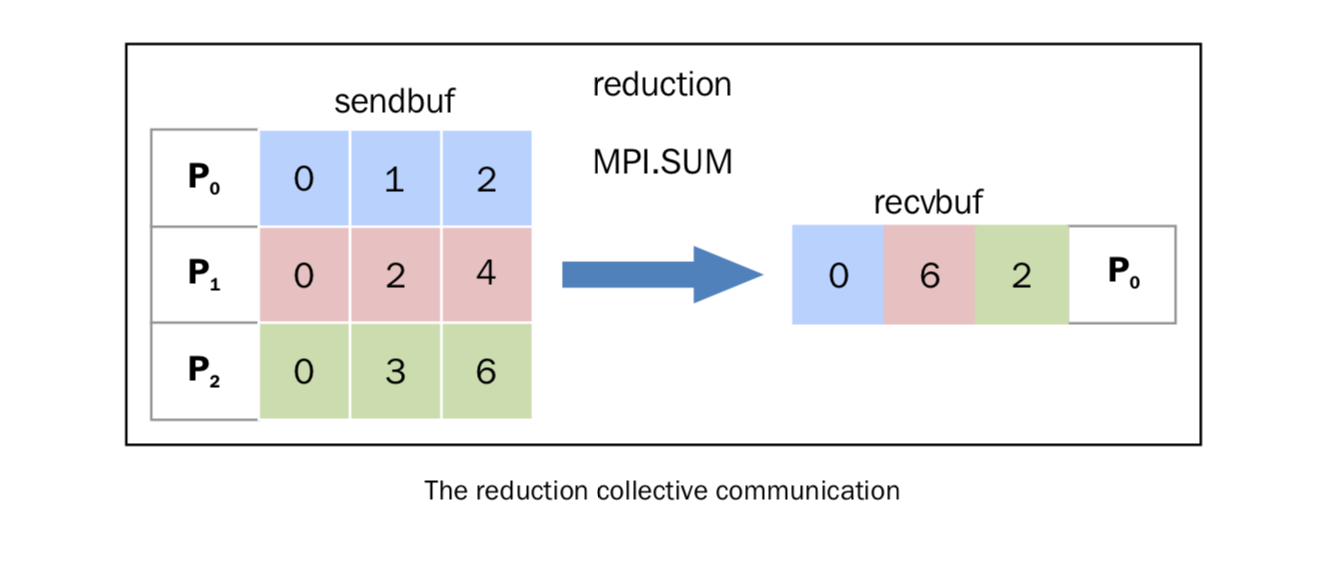

选项,将在所有的列上面应用求和操作。下图表示了这个步骤:

操作的过程如下:

- 进程 P0 发出数据数组 [0 1 2]

- 进程 P1 发出数据数组 [0 2 4]

- 进程 P2 发出数据数组 [0 3 6]

简化操作将每个 task 的第 i 个元素相加,然后放回到 P0 进程的第 i 个元素中。在接收操作中, P0 收到数据 [0 6 12]。

(译注:"简化"翻译的可能不太合适)